想象一下,拍一张照片,照片中从近处的花瓣到远处地平线上的树木,每个细节都清晰无比,无论远近。一个多世纪以来,相机设计师们一直梦想着达到这种清晰度。

据外媒报道,卡内基梅隆大学(Carnegie Mellon University)的研究人员取得了一项突破性进展,开发出一种新型镜头,能够同时清晰地呈现整个场景——无论场景中各个部分之间的距离远近。这项突破有望彻底改变摄影、显微镜技术,甚至智能手机的拍摄方式。

图片来源: 卡内基梅隆大学

该团队由电气与计算机工程博士生Yingsi Qin、电气与计算机工程教授Aswin Sankaranarayanan以及计算机科学与机器人学副教授Matthew O'Toole组成。

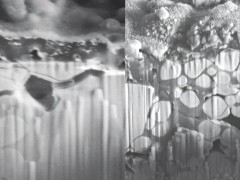

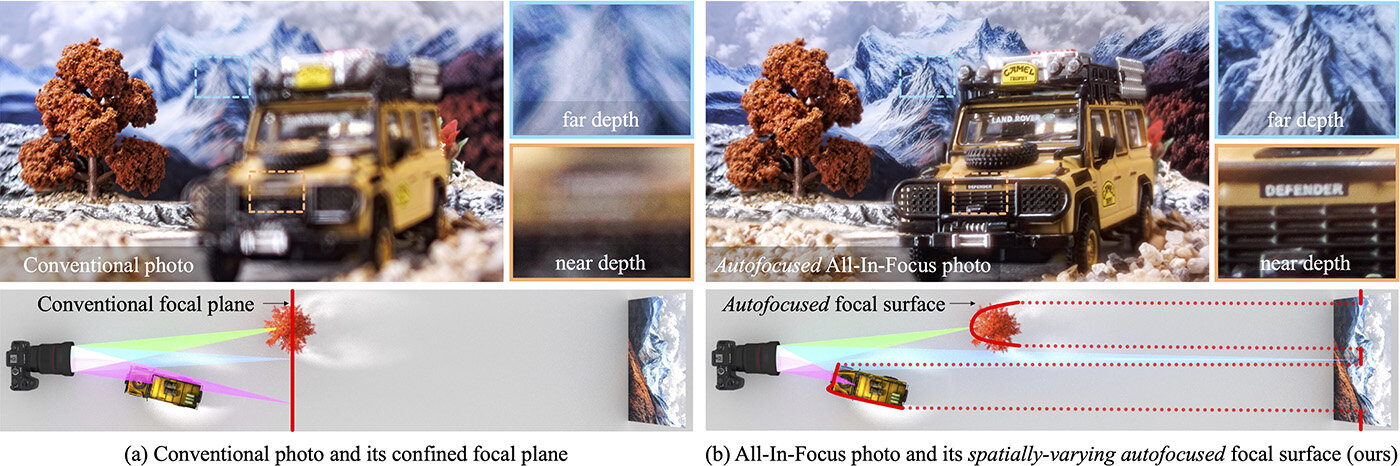

传统相机镜头一次只能将场景中的一个平面清晰对焦。位于该平面之前或之后的物体都会变得模糊不清。缩小光圈可以有所帮助,但同时也会使图像变暗,并引入由衍射引起的新型光学模糊。

“我们正在思考的问题是:‘如果镜头不必只对焦于一个平面呢?’”Qin说道,“‘如果它能够根据前方世界的形状调整焦点呢?’”

研究人员开发了一种“计算镜头”——一种光学和算法的混合体——能够针对场景中的每个部分分别调整焦距。该系统基于一种名为洛曼(Lohmann)透镜的设计,它使用两个相互移动的曲面立方体透镜来调节焦距。通过将这种装置与纯相位空间光调制器(一种控制光线在每个像素处弯曲方式的装置)相结合,研究人员能够使图像的不同部分同时聚焦于不同的深度。

该系统采用两种自动对焦方法。第一种是对比度检测自动对焦(CDAF),它将图像分割成称为超像素的区域。每个区域独立地寻找使其清晰度最大化的对焦设置。第二种是相位检测自动对焦(PDAF),它使用双像素传感器不仅检测图像是否清晰,还检测对焦方向。这使得它速度更快,更适合处理运动场景——该团队使用改进后的传感器实现了每秒21帧的拍摄速度。

“它们协同工作,让相机决定图像的哪些部分应该清晰——本质上是为每个像素配备了一个微型可调镜头,”O'Toole解释道。

除了对摄影师的明显吸引力之外,这项技术还可能拥有广泛的应用前景。显微镜可以同时捕捉生物样本的每一层清晰的图像。自动驾驶汽车或许能够以前所未有的清晰度感知周围环境。甚至增强现实和虚拟现实系统也能从中受益,利用类似的光学技术来创造更逼真的深度感知。

“我们的系统代表了一种全新的光学设计,”Sankaranarayanan说道,“它可能会从根本上改变相机观察世界的方式。”